1、然而ollama怎么下载不了,尽管功能强大,但也要注意潜在ollama怎么下载不了的错误在使用过程中,任何请求返回错误状态或在流式传输中检测到问题,Ollama Python库都会抛出异常,确保了稳定和可靠的使用体验总之,Ollama Python库为部署和管理大型语言模型提供了一个既高效又灵活的平台,无论是在本地还是在需要高性价比GPU资源的环境下,都;安装完成后,用户可以通过命令行终端直接使用ollama命令无需打开客户端软件,仅需输入相关命令即可进行操作通过ollama,用户可以轻松查看已下载的模型下载新模型,甚至启动模型对话若找不到所需模型,用户可以利用GGUF格式的模型文件自行定制Ollama支持导入或safetensors格式的模型;下载并安装Ollama打开浏览器,访问Ollama官网quot。

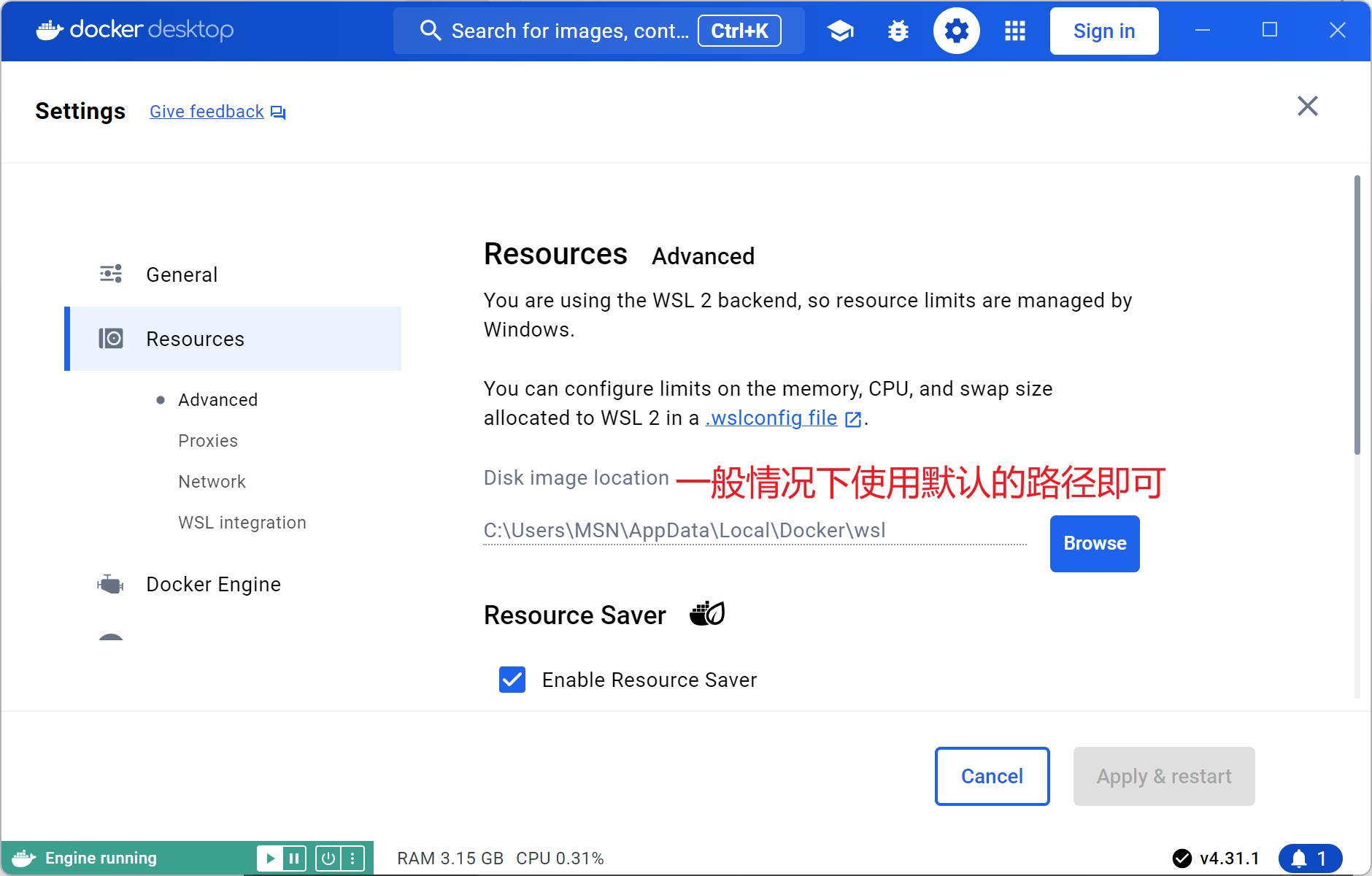

2、Ollama是一个为本地运行大型语言模型设计的开源框架,专为macOS和Linux操作系统优化,Windows用户也可通过预览版安装Ollama简化了设置和配置,支持GPU使用,易于安装,用户可从官网下载安装包并在Linux上直接运行,或在Windows的WSL 2中以Linux方式使用命令安装Ollama提供模型量化的支持,比如4bit量化;应用修改然后 systemctl restart ollamaservice 重启OLLAMA服务检查设置是否成功,运行命令 netstat ,则说明设置成功注意修改服务文件或其他systemd配置文件后,systemd不会自动检测更改因此,手动执行 daemonreload 命令至关重要,确保应用最新配置。

3、相关资源如下官方网站提供详细指导和最新资讯模型库收录各类热门LLM模型,便于选择了解如何在容器中部署ollama,进一步掌握技术要点其他关于ollama的文章,可扩展学习范围,获取更多应用案例值得一提的是,ollama的使用体验与docker高度相似,提供了便捷的模型访问途径在huggingface访问受限的情况下。

4、入门Docker + Nginx + OllamaLinux实现并发处理本文主要介绍了如何在Linux环境下利用Docker和Nginx协同工作,通过Ollama API接口实现并发处理首先,将8个Ollama API接口打包到Docker容器中,每个接口对应一个端口80108017Nginx作为一个反向代理,被部署到另一个Docker容器中,监听8020端口当。

5、安装Ollama打开浏览器,访问Ollama官网点击页面右上角的ldquoDownloadrdquo按钮根据您的电脑系统版本,选择合适的安装包进行下载下载完成后,双击安装包并按照提示完成安装安装程序可能会将Ollama直接安装在C盘,请确保C盘有足够的空间通过Ollama安装DeepSeek打开命令提示符或终端输入命令。